L'AI ha fino al 25% di probabilità di distruggere l'umanità

Dai CEO di Anthropic e Google a Elon Musk, cresce l'allarme per il cosiddetto "p(doom)": il rischio che una superintelligenza sfugga al controllo umano.

I principali leader del settore dell'intelligenza artificiale stanno esprimendo preoccupazioni sempre più serie sui rischi esistenziali della tecnologia che stanno sviluppando. Almeno dieci persone hanno abbandonato le più grandi aziende di IA per timori gravi riguardo al potenziale distruttivo della tecnologia, inclusa la possibilità che, a tendere, possa eliminare l'umanità.

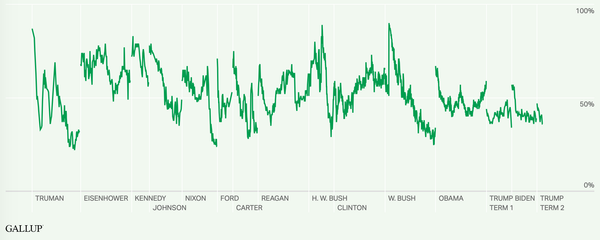

La questione centrale ruota attorno al concetto di "p(doom)", termine tecnico che indica la probabilità che un'intelligenza artificiale superiore a quella umana possa finire per distruggere l'umanità, afferma Axios in una sua analisi. Le stime fornite dai protagonisti del settore sono tutt'altro che rassicuranti: Elon Musk valuta questo rischio fino al 20%, mentre Dario Amodei, CEO di Anthropic, lo colloca in una fascia compresa tra il 10% e il 25%.

Il paradosso degli ottimisti pessimisti

Anche i più entusiasti dell'IA condividono queste preoccupazioni. Sundar Pichai, CEO di Google e architetto dell'intelligenza artificiale del gigante del web, ha recentemente ammesso durante un podcast con Lex Fridman di essere "ottimista sui scenari p(doom), ma il rischio sottostante è in realtà piuttosto alto". Fridman stesso, scienziato e ricercatore di IA, ha dichiarato di stimare il p(doom) intorno al 10%.

La particolarità di questi dati risiede nel fatto che provengono proprio dai creatori della tecnologia, i quali ammettono apertamente di non conoscere con precisione come essa funzioni realmente. Come sottolineato nel dibattito, nessuno salirebbe su un aereo con probabilità di incidente del 10-20%, eppure questi sono i rischi che i produttori di IA attribuiscono alla propria tecnologia.

Il mistero del funzionamento degli LLM

Il problema fondamentale è che rappresenta ancora un mistero per le aziende di IA il motivo e il modo in cui i modelli linguistici di grandi dimensioni (LLM) funzionino effettivamente. I creatori conoscono i dati che inseriscono nelle macchine e i modelli generali che gli LLM utilizzano per rispondere alle domande e "pensare", ma non sanno perché gli LLM rispondano nel modo in cui lo fanno.

Per raggiungere il valore di migliaia di miliardi di dollari, le aziende hanno bisogno che questi sistemi analizzino e "pensino" meglio degli umani più intelligenti, lavorando poi indipendentemente su problemi complessi che richiedono ragionamento sofisticato e capacità decisionali. Questo è il funzionamento dei cosiddetti agenti IA.

Come ha scritto la scorsa settimana Sam Altman, CEO di OpenAI: "Stiamo costruendo un cervello per il mondo (tutta l'industria, non solo OpenAI)."

Verso l'intelligenza artificiale generale

Il settore si sta così rapidamente avvicinando alla realizzazione dell'intelligenza generale artificiale (AGI), considerata come precursore diretto della super-intelligenza. Sebbene non esista una definizione rigorosa di AGI, il pensiero e l'azione indipendenti a livelli umani avanzati ne costituiscono una componente fondamentale. Le grandi aziende ritengono di essere vicine a raggiungere questo obiettivo: se non nel prossimo anno, sicuramente poco dopo. Pichai stima che manchino "un po' più di cinque anni", mentre altri prevedono tempi più brevi.

Il punto è: una volta che i modelli di intelligenza artificiale inizieranno a pensare e agire autonomamente, cosa li impedirà di diventare incontrollabili e di fare ciò che vogliono, basandosi su quello che calcolano essere il loro interesse personale? In assenza di una comprensione molto più approfondita di come funzionano gli LLM rispetto a quella attuale, la risposta è: non molto.

Inganni e manipolazioni nei test

Durante i test più recenti, gli ingegneri hanno scoperto ripetuti esempi di LLM che cercano di ingannare gli esseri umani riguardo alle loro intenzioni e ambizioni. Si può immaginare quanto più astuti potrebbero essere quelli a livello AGI.

Servirebbe perciò un meccanismo per riconoscere quando gli LLM possiedono questa capacità prima che vengano utilizzati o rilasciati, oltre a un interruttore di emergenza infallibile per fermarli se necessario. Attualmente non esiste né uno né l'altro e ci si deve fidare che le aziende del settore non permettano che questo accada, nonostante siano sotto tremenda pressione da parte di azionisti, dirigenti e persino del governo per essere le prime a produrre un'intelligenza artificiale superiore a quella umana.

La corsa agli armamenti internazionale

Al momento, le aziende condividono volontariamente le capacità dei loro modelli con alcune persone all'interno del governo federale, ma non con il Congresso o altre terze parti con autorità reale su questo campo. Non è perciò difficile immaginare una Casa Bianca che, temendo che la Cina ottenga il controllo di una intelligenza artificiale superiore a quella umana prima degli Stati Uniti, decida di abbandonare qualsiasi forma di controllo sull'IA.

Anche se le aziende statunitensi agissero responsabilmente, o se il governo americano intervenisse per imporre e utilizzare un interruttore di emergenza, il futuro dell'umanità potrebbe dipendere dal fatto che la Cina o altri attori stranieri facciano lo stesso.

Quando gli è stato chiesto se il governo americano potrebbe davvero intervenire per fermare un pericolo IA fuori controllo, il vicepresidente J.D. Vance ha ammesso al giornalista del New York Times Ross Douthat:

"Non lo so. Perché parte di questa componente di corsa agli armamenti è: se noi facciamo una pausa, altri la faranno? Altrimenti rischiamo di trovarci schiavi di un'IA super intelligente proveniente dalla Cina."